Des serveurs IA signés Qualcomm pour concurrencer Nvidia

Contrairement à son modèle commercial habituel où Qualcomm fournit uniquement des puces, l'entreprise a conçu des systèmes complets au niveau rack destinés à être directement intégrés dans les centres de données.

Contrairement à son modèle commercial habituel où Qualcomm fournit uniquement des puces, l'entreprise a conçu des systèmes complets au niveau rack destinés à être directement intégrés dans les centres de données. Le géant californien des semi-conducteurs a officiellement annoncé son retour sur le marché des puces pour serveurs avec les AI200 et AI250. Cette offensive signe l'ambition du spécialiste des processeurs mobiles sur le marché très lucratif de l'infrastructure IA, dominé par Nvidia, Intel et AMD.

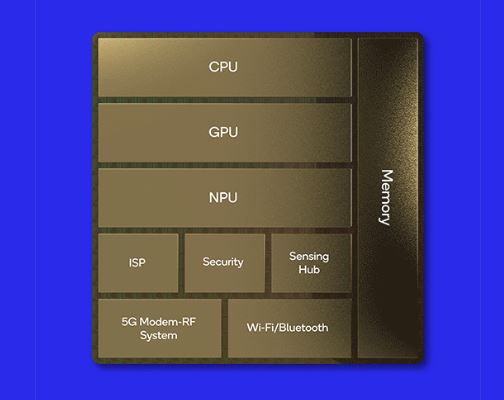

Qualcomm vient de franchir un cap dans sa stratégie de diversification au-delà des smartphones en annonçant officiellement son retour sur le marché des serveurs (voir encadré Centriq 2400) et plus précisément des systèmes dédiés à l'inférence IA. Le géant californien des semi-conducteurs dévoile deux solutions complètes baptisées AI200 et AI250, destinées à concurrencer directement les solutions rack de Nvidia, Intel et AMD dans les datacenters. Sans surprise, ces serveurs embarquent des puces reposant sur l'architecture Arm et exploitent les unités de traitement neuronal (NPU) Hexagon que la firme de San Diego a développé pour ses processeurs mobiles et PC. Si Qualcomm ne fournit aujourd'hui que peu de détails techniques sur ses deux systèmes, notamment la partie CPU. Le site du fournisseur précise que sa puce AI Engine - employée dans des terminaux mobile - combine CPU (Oryon), GPU (Adreno) et NPU (Hexagon) exploitant les technologies issues du rachat de Nuvia. Le transfert de ces technologies vers le datacenter constitue une évolution logique pour l'entreprise californienne, qui capitalise ainsi sur son expertise en matière d'efficacité énergétique. La société a progressivement amélioré ses NPU Hexagon ces dernières années, de sorte que les dernières versions de ces processeurs intègrent déjà des accélérateurs scalaires, vectoriels et tensoriels (dans une configuration 12+8+1) et prennent en charge des formats de données tels que INT2, INT4, INT8, INT16, FP8, FP16, l'inférence micro-tile pour réduire le trafic mémoire, l'adressage mémoire 64 bits, la virtualisation et le chiffrement des modèles GenAI pour une sécurité supplémentaire. L'adaptation d'Hexagon aux charges de travail des centres de données est un choix naturel pour Qualcomm, même s'il reste à voir quels objectifs de performance la société fixera pour ses unités AI200 et AI250.

Sans informations précises, on ne peut que supposer que l'AI200 sera équipé d'une évolution de la puce AI Engine de Qualcomm, sans la partie radio bien sûr. (Crédit Qualcomm)

L'AI200, dont la commercialisation est prévue pour 2026, se caractérise par une grande capacité mémoire avec 768 Go de LPDDR par carte, plutôt que la mémoire HBM traditionnellement employée par Nvidia et AMD. Cette configuration vise spécifiquement les charges de travail d'inférence IA nécessitant d'importantes ressources mémoire pour exécuter des modèles de langage volumineux. Les systèmes AI200 seront livrés sous forme de racks complets consommant 160 kW et utilisant un refroidissement liquide direct, avec des interconnexions PCIe pour la montée en charge et des liens Ethernet pour l'extension horizontale. La génération suivante, l'AI250 attendue en 2027, promet des avancées encore plus significatives grâce à une architecture de calcul proche de la mémoire (near-memory computing). Cette innovation devrait multiplier par dix la bande passante mémoire effective tout en réduisant considérablement la consommation électrique. L'AI250 introduira également une capacité de calcul désagrégé - via CXL - permettant de partager dynamiquement les ressources de calcul et de mémoire entre les cartes CPU.

Réduire la consommation des datacentersQualcomm met en avant l'argument du coût total de possession (TCO) comme principal atout de ses solutions, insistant sur leur faible consommation énergétique comparée aux alternatives du marché. Les puces sont spécifiquement conçues pour l'inférence IA, c'est-à-dire l'exécution de modèles déjà entraînés plutôt que leur apprentissage initial, un segment en pleine expansion dans les datacenters. Durga Malladi, vice-président senior de Qualcomm, a souligné que ces innovations visent à "redéfinir ce qui est possible pour l'inférence IA à l'échelle rack" tout en permettant aux clients de "déployer l'IA générative avec un coût total de possession sans précédent". L'argumentaire commercial principal de Qualcomm repose en effet sur l'efficacité énergétique et la réduction des coûts opérationnels par rapport aux solutions concurrentes d'AMD, Intel et Nvidia. L'annonce s'accompagne d'un accord commercial majeur avec Humain, la société d'intelligence artificielle adossée au fonds souverain saoudien. Ce partenariat, qui prévoit un déploiement de 200 MW, verra les premiers datacenters équipés des solutions Qualcomm entrer en service dès 2026. Cette collaboration s'inscrit dans le cadre d'un mémorandum d'accord signé en mai 2025 entre Qualcomm et Humain pour développer des datacenters IA en Arabie Saoudite et ailleurs dans le monde. Selon les analystes de Wolfe Research, cette transaction pourrait représenter environ un milliard de dollars, bien moins que les 15 milliards de dollars par gigawatt du récent accord conclu par AMD avec OpenAI.

Qualcomm a par ailleurs confirmé maintenir une cadence annuelle de lancement pour ses futurs produits datacenter, avec une troisième génération déjà planifiée pour 2028. Cette stratégie vise à établir une présence durable sur un marché évalué à plusieurs milliards de dollars, dominé jusqu'ici par Nvidia qui détient la majorité des parts sur les accélérateurs IA. Au-delà du matériel, Qualcomm a également développé une plateforme logicielle complète optimisée pour l'inférence à grande échelle. Cette solution supportera les principaux outils d'apprentissage automatique et d'IA générative, notamment PyTorch, ONNX, vLLM, LangChain et CrewAI, tout en facilitant le déploiement transparent de modèles pré-entraînés. La plateforme intégrera également le calcul confidentiel pour les déploiements d'entreprise et permettra l'intégration en un clic de modèles préentraînés.

Un enjeu à long terme pour QualcommL'action Qualcomm a bondi de plus de 20% lundi 27 octobre après cette annonce, reflétant l'optimisme des investisseurs quant à cette diversification stratégique. Les analystes restent toutefois prudents sur les spécifications techniques révélées, Wolfe Research notant que la plateforme de Qualcomm semble moins avancée que les offres actuelles de Nvidia, AMD et Broadcom, notamment en raison de l'utilisation de mémoire LPDDR plutôt que HBM et de PCIe et Ethernet au lieu de NVLink et Infiniband pour la montée en charge. Reste à déterminer si ces solutions arm pourront véritablement ébranler la domination de Nvidia, Intel et AMD, qui bénéficient d'écosystèmes logiciels bien établis et de relations solides avec les principaux acteurs cloud. Scott Young, directeur principal des services-conseils chez Info-Tech Research Group, a souligné que l'apprentissage est lié à la puissance de calcul et tolérant au temps, tandis que l'inférence est liée à la mémoire et/ou à la latence et « vraisemblablement continue ». Ces deux processus nécessitent des types de serveurs différents, a-t-il fait remarquer. Le matériel d'apprentissage est coûteux et, bien qu'il puisse être utilisé pour l'inférence, il n'est pas toujours optimal. La demande en matière d'inférence continuera de croître à mesure que les entreprises déploieront davantage d'IA agentique, a-t-il déclaré. « Le hardware spécialement conçu pour l'inférence peut être plus rentable et peut être adapté de manière appropriée à la croissance rapide de l'utilisation de ces modèles d'IA », a expliqué M. Young.

D'un point de vue stratégique, il s'agit là d'un enjeu à plus long terme pour les entreprises, a fait remarquer M. Kimball de Moor. Humain (spécialiste de l'IA en Arabie Saoudite) est le premier client de Qualcomm, et un fournisseur de services cloud (CSP) ou un hyperscaler sera probablement le deuxième client. Cependant, à un moment donné, ces systèmes à l'échelle d'un rack trouveront leur place dans l'entreprise. « Si j'étais responsable du marketing produit AI200, je réfléchirais à la manière de présenter cette plateforme comme une solution viable pour les charges de travail des entreprises qui seront « agentifiées » au cours des prochaines années », a souligné M. Kimball. Cela semble être une étape naturelle, car Qualcomm a connu le succès avec son accélérateur AI100, une puce d'inférence puissante, a-t-il expliqué. À l'heure actuelle, Nvidia et AMD dominent le marché de la formation, Cuda et ROCm bénéficiant d'une fidélité de la part des clients. « Si je suis un géant des semi-conducteurs comme Qualcomm, qui comprend si bien l'équilibre entre performances et puissance, ce marché de l'inférence est tout à fait logique », a indiqué M. Kimball. Il a également souligné les projets de la société de revenir sur le marché des processeurs pour centres de données avec son processeur Oryon, qui équipe le Snapdragon et s'inspire librement de la technologie acquise lors de son rachat de Nuvia pour 1,4 milliard de dollars. En fin de compte, la décision de Qualcomm démontre à quel point le marché de l'inférence est ouvert, a raconté l'analyste. Il a souligné que l'entreprise avait toujours su choisir avec justesse ses marchés cibles et avait rencontré le succès lorsqu'elle s'était lancée sur ces marchés. « Il est logique que l'entreprise décide de s'investir davantage sur le marché de l'inférence », a déclaré M. Kimball. Il a ajouté que, du point de vue du retour sur investissement, l'inférence « éclipsera » la formation en termes de volume et de dollars.

Edition du 03/11/2025, par Serge Leblal avec IDG NS

Sur le même sujet