Le CEO de Nvidia, Jensen Huang, a dévoilé le Project Digits lors d'un discours liminaire à la veille du CES 2025, le salon de l'électronique qui se tient à Las Vegas du 7 au 11 janvier 2025. (Crédit Nvidia)

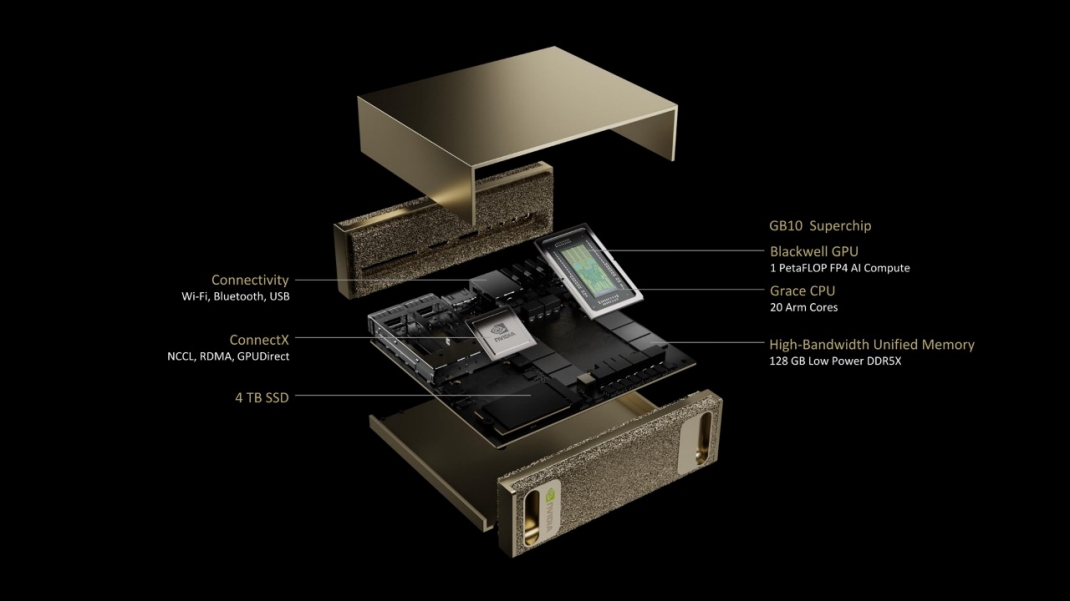

La station de travail compacte de Nvidia pour l'entraînement des modèles d'intelligence artificielle repose sur puce SoC GB10 Grace Blackwell Superchip.

Nvidia a construit son activité autour de l'intelligence artificielle générative (IA générative) en offrant une capacité de calcul massive aux centres de données où elle peut être utilisée pour entraîner et affiner les grands modèles de langage (LLM). Désormais, la société se prépare à lancer une station de travail compacte baptisée Project Digits, une sorte de "supercalculateur personnel pour l'IA" dotée d'une version allégée de la plateforme Grace Blackwell, présente dans ses serveurs les plus puissants. Ce produit cible les développeurs, les data scientists, les chercheurs et les étudiants qui pourront prototyper, ajuster et exécuter localement des modèles d'IA générative de grande taille.

Le Project Digits est de taille similaire au Mac Mini d'Apple et au client léger Windows 365 Link de Microsoft, présenté en novembre 2024. Ce dernier terminal mesure 120 mm (4,72 pouces) de côté et 30 mm (1,18 pouce) de hauteur. (Crédit Nvidia)

Nvidia n'a pas communiqué les dimensions précises de Project Digits, mais selon Allen Bourgoyne, directeur du marketing produit chez Nvidia, l'appareil, de forme carrée, serait aussi large qu'une tasse à café avec anse et environ deux fois moins haut. Les mugs mesurent généralement environ 120 mm de largeur, anse comprise, et environ 90 mm de hauteur. Project Digits aurait donc la même largeur que le Link de Microsoft, mais serait environ 50 % plus épais. Cependant, la comparaison s'arrête là. Les philosophies derrière ces deux appareils sont radicalement différentes : tandis que le Link externalise presque toute la capacité de calcul vers le cloud, le dispositif de Nvidia ramène cette puissance sur le bureau.

Un seul branchement mural pour un pétaflop

Contrairement au Link de Microsoft (349 $HT), qui est équipé de 8 Go de RAM, ne dispose d'aucun stockage local et utilise un processeur Intel sans capacités spéciales d'IA, le Project Digits coûtera plus de 3 000 $HT lors de sa sortie prévue en mai. Ce prix inclut 4 To de stockage Flash NVMe, 128 Go de mémoire DDR5X (unifiée et basse consommation), et surtout une puce SoC GB10 Grace Blackwell Superchip comprenant 20 coeurs Arm pour la partie CPU Grace et une combinaison de coeurs Cuda, coeurs RT et coeurs Tensor de cinquième génération pour la partie GPU Blackwell. Ces composants combinés offrent une capacité de calcul atteignant 1 pétaflop pour le traitement de l'IA, soit suffisamment pour travailler avec un modèle de 200 milliards de paramètres à une précision « FP4 » localement, sans avoir besoin du cloud. En connectant deux boitiers Project Digits via leurs puces de réseau ConnectX intégrées, il est possible de traiter des modèles atteignant 400 milliards de paramètres, selon M. Bourgoyne.

La puce GB10 a été co-développée avec Mediatek, une entreprise connue pour ses puces mobiles économes en énergie. Comparé aux processeurs GB200 utilisés dans les centres de données, où un rack NV72 peut consommer jusqu'à 120 kW, le Project DIGITS est bien plus économe. « Vous pouvez le brancher sur une prise murale standard », a expliqué A. Bourgoyne. « Il ne nécessite pas plus d'énergie que ce que consomme un bureau classique. »

Un système d'exploitation optimisé pour l'IA

Le Project Digits ne fonctionnera pas sous Windows, mais utilisera DGX OS, une version d'Ubuntu Linux personnalisée avec des pilotes et outils supplémentaires pour le développement et l'exécution d'applications d'IA. Ce système est le même que celui utilisé sur les systèmes DGX de Nvidia dans les centres de données, ce qui signifie que les modèles construits et testés localement sur Project Digits peuvent être directement déployés sur le cloud ou en data center. Par ailleurs, d'autres outils d'IA développés par Nvidia pourront être exécutés sur l'appareil, notamment des outils d'orchestration, des frameworks et des modèles disponibles sur le portail des développeurs Nvidia et dans son NGC (Nvidia GPU Cloud). Cela inclut le framework NeMo pour le perfectionnement des modèles et les bibliothèques Rapids pour la science des données. Les Blueprints de Nvidia et les microservices NIM sont accessibles sous licences légères via son programme développeur pour la création d'applications d'IA autonomes, avec une licence AI Enterprise nécessaire uniquement pour le passage en environnement de production.

Davantage de GenAI sur le bureau

Le fournisseur de Santa Clara reconnaît que l'on n'a pas forcément besoin d'une puce GB10 pour accélérer le développement d'IA sur un bureau. C'est pourquoi l'entreprise introduit également une gamme de microservices NIM et de Blueprints d'IA pour la création d'applications sur des PC équipés de ses GPU Geforce RTX - qu'elle appelle les PC RTX AI. Nvidia propose une gamme de modèles d'IA de base - à la fois les siens et ceux d'autres développeurs - conteneurisés en tant que microservices NIM téléchargeables et connectables entre eux. À l'aide d'outils low-code et no-code tels qu'AnythingLLM, ComfyUI, Langflow et LM Studio, les développeurs pourront concevoir et déployer des workflows utilisant ces microservices NIM. Les Blueprints d'IA de Nvidia fourniront des workflows préconfigurés pour des tâches spécifiques, comme la conversion de formats de médias. L'un des Blueprints les plus récents permet par exemple de convertir des fichiers PDF en podcasts.

Suivez-nous