Avec AMD, HPE proposera en 2026 la baie Helios, 1e solution scale-up utilisant l'Ethernet standard capable d'entraîner des modèles à mille milliards de paramètres et de délivrer 2,9 exaflops de performance en FP4, a indiqué Rami Rahim, président de HPE Networking (Crédit HPE)

Cinq mois après la finalisation du rachat de Juniper Networks, HPE a dévoilé lors de sa conférence Discover Europe 2025 à Barcelone une stratégie réseau ambitieuse et des équipements haute performance destinés aux infrastructures IA et aux datacenters de nouvelle génération.

Avec près de 5 000 personnes attendues (clients, partenaires et employés), l'événement HPE Discover Europe 2025, qui se tient du 3 au 5 décembre à Barcelone, marque un tournant stratégique pour le fournisseur américain dans le domaine du réseau. Lors de sa keynote inaugurale, Antonio Neri, le CEO de HPE, a rapidement passé la main à Rami Rahim, aujourd'hui président et directeur général de HPE Networking. Ce dernier a présenté les premiers fruits de l'intégration de Juniper Networks, acquis en juillet 2025, aux côtés des équipes historiques de HPE Aruba. Cette fusion crée désormais un géant du réseau capable de répondre aux exigences croissantes des datacenters, des opérateurs télécoms et des hyperscalers confrontés aux besoins massifs de l'intelligence artificielle. « Nous réunissons deux entreprises réseau incroyables, des personnes exceptionnelles, une technologie de classe mondiale, et nous les combinons de la manière la plus efficace pour résoudre de vrais problèmes », a déclaré Rami Rahim en ouverture de sa keynote. Fort de près de 30 ans d'expérience dans l'industrie du réseau, le dirigeant a souligné l'importance historique de ce moment pour HPE et pour l'ensemble du secteur.

Une intégration accélérée des plateformes AIOps

L'un des axes majeurs de cette stratégie repose sur la convergence des deux plateformes d'opérations réseau pilotées par l'IA : HPE Aruba Networking Central et Juniper Networking Mist. Ces deux solutions complémentaires analysent les données de milliards d'appareils connectés depuis plus d'une décennie, constituant l'un des plus vastes lacs de données du secteur. Les clients ayant adopté ces plateformes ont constaté une réduction allant jusqu'à 90% des tickets d'incident et des interventions sur site, selon le dirigeant. HPE annonce que les fonctionnalités phares de chaque plateforme seront désormais disponibles sur l'autre : le Large Experience Model (LEM) de Mist, qui utilise des milliards de points de données provenant d'applications comme Zoom et Teams, sera intégré à Aruba Central. Inversement, la technologie Agentic Mesh d'Aruba enrichira Mist pour améliorer la détection des anomalies et l'analyse des causes racines. « À l'ère de l'IA, les clients ont besoin de réseaux conçus avec l'IA et pour l'IA, capables de gérer la croissance rapide des appareils connectés, les environnements complexes et les menaces de sécurité croissantes », a affirmé Rami Rahim. Cette vision se traduit par le concept de réseaux « auto-pilotés » (self-driving networks), capables de se configurer, s'optimiser et se réparer de manière autonome.

Le WiFi unifié comme première étape

Un symbole fort de cette intégration réside dans l'annonce du premier point d'accès WiFi 7 bi-plateforme, compatible à la fois avec Mist et Aruba Central. Cette innovation, prévue pour le troisième trimestre 2026, garantit aux entreprises une protection de leurs investissements, quelle que soit la plateforme choisie. HPE s'est d'ailleurs hissé au rang de premier fournisseur mondial de WiFi par volume d'unités livrées dans le secteur de l'enseignement supérieur, selon le rapport 650 Group. Des établissements prestigieux comme l'Université d'Édimbourg et l'Imperial College de Londres ont déjà adopté la plateforme de données réseau IA de HPE. Dans le secteur de la santé, le Netherlands Cancer Institute et la Croix-Rouge autrichienne utilisent les solutions réseau HPE pour optimiser l'expérience patient tout en garantissant une connectivité sécurisée, a remonté le dirigeant.

Des réseaux taillés pour les charges de travail IA

« En proposant des réseaux autonomes, auto-configurables, auto-optimisés et auto-réparables, nous donnons aux administrateurs réseau et aux équipes IT le pouvoir de se concentrer sur les initiatives stratégiques plutôt que sur la gestion quotidienne des opérations réseau », a expliqué Rami Rahim. Cette approche répond à une réalité : les charges de travail d'intelligence artificielle présentent des caractéristiques fondamentalement différentes des applications traditionnelles. L'entraînement de modèles nécessite un trafic est-ouest massif entre serveurs, tandis que l'inférence exige une latence ultra-faible. Ces deux types de charges requièrent une échelle et une fiabilité sans précédent, combinées à une sécurité intégrée dès la conception. Les réseaux traditionnels n'ont tout simplement pas été conçus pour ces usages. HPE propose désormais une gamme complète de solutions de commutation, de gestion de fabric et de sécurité adaptées aux exigences spécifiques des workloads IA. L'intégration avec GreenLake permet de fournir des solutions de datacenter de bout en bout couvrant le compute, le stockage et le réseau avec : le switch QFX5250, le routeur MX301 et le firewall SRX4700.

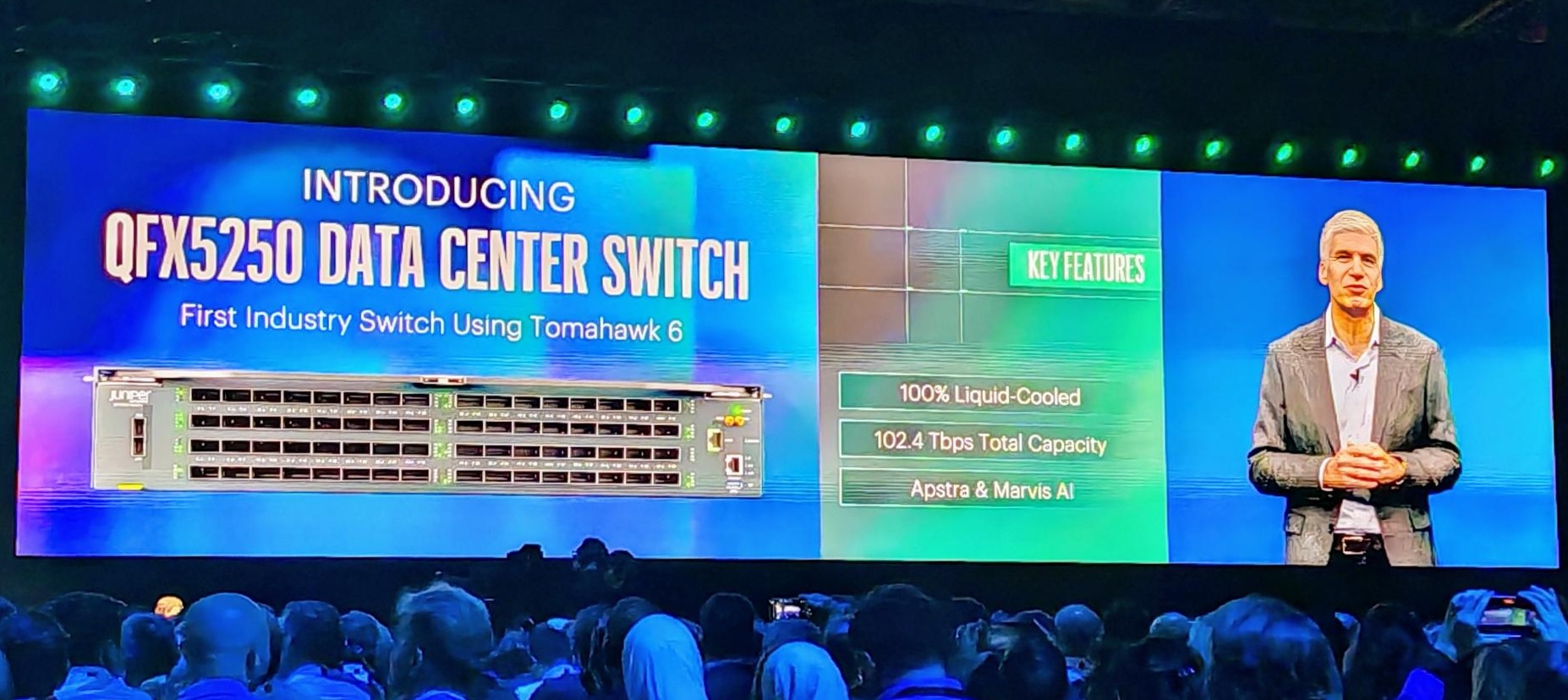

Le QFX5250 est présenté par HPE comme le switch Ethernet 1,6 Tbit/s par port le plus performant du marché, basé sur le silicium Broadcom Tomahawk 6 et conçu pour des environnements 800G/1,6T à très forte densité. (crédit S.L.)

Annoncé lors de HPE Discover, le QFX5250 constitue la première utilisation OEM du silicium Broadcom Tomahawk 6. « C'est le switch Ethernet 1,6 térabit par seconde le plus performant au monde, 100% refroidi par liquide, compatible Ultra Ethernet Transport, idéal pour la connectivité scale-up de nouvelle génération en front-end et back-end », s'est enthousiasmé Rami Rahim. Ce commutateur affiche une bande passante totale de 102,4 Tbps et combine l'innovation logicielle Junos OS, l'expertise HPE en refroidissement liquide acquise dans le HPC, et le contrôle assuré par AIOps. Il est spécifiquement conçu pour connecter les GPU (AMD ou Nvidia) au sein des datacenters, répondant aux besoins des clusters pouvant dépasser 100 000 accélérateurs. Sa disponibilité est prévue pour le premier trimestre 2026.

MX301 : l'inférence IA au plus près des données

Le routeur multiservice MX301 répond à un besoin croissant : rapprocher l'inférence IA de l'endroit où les données sont générées, à la périphérie du réseau. Ce routeur compact au format 1U délivre des performances de 1,6 Tbps avec une connectivité 400G, adapté aux environnements d'inférence, multiservice, métropolitains, backhaul mobile et routage d'entreprise, a expliqué le dirigeant. Le MX301 hérite de la puce personnalisé Trio, qui confère à la gamme MX une grande flexibilité pour répondre aux besoins réseau actuels et futurs. Le produit sera disponible dès décembre 2025.

Enfin, le SRX4700 se positionne comme un des pares-feux parmi les plus rapides au monde et le premier à intégrer une protection quantique. En un seul rack unit, il délivre 1,4 Tbps de débit sécurisé, là où les solutions concurrentes nécessitent jusqu'à 14 unités de rack pour atteindre des performances équivalentes, selon Rami Rahim. Cette densité en fait une solution adaptée aux charges de travail IA exigeantes où la sécurité ne peut être un goulot d'étranglement. Dans les AI factory modernes, où des volumes massifs de données doivent transiter vers les GPU avec une latence minimale et sans interruption, ce pare-feu garantit une inspection du trafic sans compromettre les performances, rapporte le dirigeant.

Helios démocratise les AI factories pour hyperscalers et entreprises en évitant la dépendance à Nvidia. (crédit AMD)

AMD Helios : la réponse ouverte aux DGX de Nvidia

HPE a également annoncé l'extension de ses partenariats avec Nvidia et AMD. Les routeurs MX et PTX sont désormais qualifiés pour les solutions AI factory du premier, tant pour les usages en périphérie que pour l'interconnexion longue distance entre datacenters. Le fournisseur accélère surtout la concurrence directe aux systèmes DGX de Nvidia avec le lancement mondial en 2026 de la plateforme rack-scale Helios (déjà présenté au dernier OCP Summit et à Super Computing 2025) première référence AI conçue par AMD et conforme au standard Open Rack V3 de Meta (avec refroidissement liquide et un design optimisé pour la dissipation thermique) au sein de l'Open Compute Project. Cette architecture ouverte pour charges IA massives repose ici sur des serveurs Proliant avec des processeurs CPU Epyc de 5e génération (Turin Dense) offrant jusqu'à 192 coeurs par socket, couplés à 8 GPU Instinct MI350X par rack, capables de délivrer 2,9 exaflops en FP4 pour l'entraînement de modèles à mille milliards de paramètres. Le réseau repose sur un design switch scale-up Ethernet exclusif HPE Juniper, premier du genre utilisant la puce Broadcom Tomahawk 6 (dans le QFX5250), avec 102,4 Tbps de bande passante totale, 100% refroidi par liquide et compatible avec le protocole Ultra Ethernet Transport - concurrent de l'Infiniband de Nvidia - pour une latence ultra-faible et une interconnexion sans verrouillage propriétaire entre accélérateurs intra-rack. « C'est une première absolue qui porte l'Ethernet à un nouveau niveau du datacenter AI », a pointé Rami Rahim.

Le dirigeant de l'entité réseau de HPE résume l'ambition de ce portefeuille en le reliant à la dynamique de l'intégration Juniper‑HPE : « Moins de six mois après la clôture de la fusion, nous montrons déjà de nouveaux produits et solutions sur le show floor ; cela prouve que nous avons la vision, les équipes et l'échelle industrielle pour mener l'industrie vers une nouvelle génération de réseaux. » Avec ces annonces, HPE envoie un signal clair aux entreprises, opérateurs et hyperscalers : le réseau, de plus en plus autonome, devient la pièce maîtresse des déploiements d'IA à grande échelle, où chaque micro‑coupure de flux GPU peut désormais se traduire en perte de temps d'apprentissage et de valeur métier.

Suivez-nous