Suivant la tendance générale, HPE dévoile à l'occasion de son évènement annuel plusieurs agents IA au sein de son offre Greenlake. Ils s'orientent vers l'AIOps, le réseau et le stockage.

La foule était nombreuse à se réunir au sein de la Sphere à Las Vegas pour écouter le discours d'ouverture d'Antonio Neri, CEO de HPE à l'occasion de l'évènement Discover (du 23 au 25 juin). Comme ses concurrents, le fournisseur a clairement marqué ses ambitions dans les agents IA. « Ils transforment fondamentalement notre façon d'interagir et de gérer les idées. Nous allons au-delà d'une IA qui se contente d'analyser et de recommander, vers une nouvelle équipe d'administrateurs », explique le dirigeant. Ces derniers « optimiseront en permanence votre infrastructure et résoudront les problèmes, vous permettant ainsi de gagner du temps et de l'argent ». Tout naturellement, les agents IA dévoilés par HPE ont trouvé leur place dans l'offre Greenlake Intelligence dévoilée l'année dernière.

Pour Antonio Neri, « elle repose sur un maillage d'agents IA qui collaborent, apprennent et agissent en contexte sur l'ensemble de votre parc informatique hybride ». Ces agents se servent de « LLM spécifiques à chaque domaine, optimisés grâce aux informations issues d'un historique de télémétrie de HPE, de données de configuration et de support couvrant des milliards de points de données ». Le dirigeant voit la diffusion des agents IA dans plusieurs directions : l'AIOps, le réseau et le stockage.

Les agents IA mobilisés pour l'AIOps

Sur le premier point, Varna Kunaparaju, VP et responsable logiciel OpsRamp et plateformes cloud (ancien CEO d'OpsRamp racheté par HPE en 2023), indique « les agents collectent des données de différents services (observabilité, finops, greenops, la sécurité) ou ressources (réseau, stockage et calcul) ». A travers le copilot de Greenlake Intelligence, ils peuvent intervenir sur différents problèmes. Le responsable prend le cas « de la source d'un problème (root cause) qui va être gérer par la solution de l'observabilité. Elle va s'appuyer sur plusieurs agents, celui qui gère les logs, un autre les traces et un autre les séries temporelles. Chacun va remonter des informations et déterminer les problèmes rencontrés. Le copilot va apporter du raisonnement et de la contextualisation pour définir par exemple que la source du problème provient d'un port sur un commutateur. La résolution pourra alors être effectué automatiquement ou par un humain en fonction de la gravité ». A la question de savoir avec quels LLM les agents ont été développés, Varna Kunaparaju précise, « dans le cas de l'observabilité, nous nous sommes servis de Gemini de Google et du framework Langgraph pour l'orchestration et enfin de MCP (model context protocol) ».

Varna Kunaparaju, VP et responsable logiciel OpsRamp et plateformes cloud chez HPE a détaillé les agents utilisés pour l'AIOps. (Crédit Photo: JC)

Pour lui, la question de l'interopérabilité est « essentielle, car je crois qu'aucun modèle de raisonnement ne sera un gagnant universel. MCP est une des approches qui est maintenant largement adoptées ». Sur le protocole open source promu par Anthropic, le dirigeant estime que « MCP va travailler comme une API pour faire raisonner l'agent en étant indépendant du modèle, du framework, du domaine... » Autre point de surveillance, la sécurité des agents, « les créateurs de modèles ont mis en place des garde-fous, il faut les évaluer. Le second point est l'affinage les modèles avec des données anonymisées. Les agents IA sont encore jeunes et la sécurité devra évoluer avec le temps », observe-t-il. Sur l'aspect tarifaire, il reste pragmatique « nous ne voulons pas faire les mêmes erreurs que Salesforce », une référence à l'abandon du paiement de 2 $ par conversation au sein d'Agentforce. « Nous pensons qu'il est nécessaire d'offrir une certaine capacité d'IA sans la facturer séparément », poursuit-il. La réflexion est néanmoins de mise à terme, « au fur et à mesure que nous créons de plus en plus de valeur, nous en ferons une capacité supplémentaire. Elle ne se fera pas par requête, mais plutôt par ressources. Par exemple, une licence d'entreprise vous donnera une certaine quantité d'IA pour votre environnement ».

Un maillage d'agents IA pour le réseau et MCP en natif pour le stockage

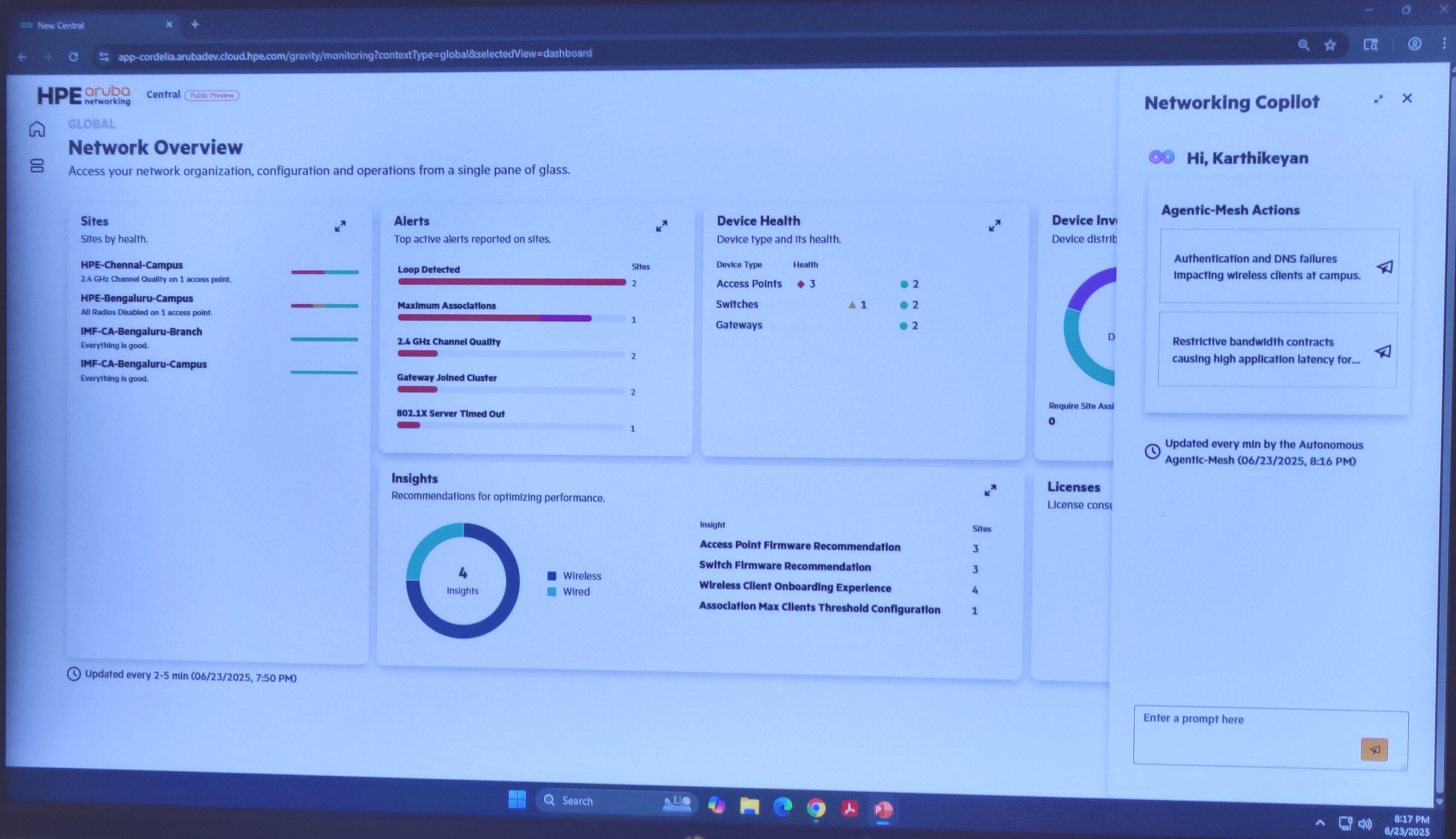

L'autre offre à bénéficier de l'IA agentique est Aruba Networking Central au sein de Greenlake Intelligence. Pour David Hughes, SVP et responsable produit Aruba Networking, « nous avons créé un maillage d'agents pour que chacun apporte son expertise dans l'analyse d'un problème ou d'une panne réseau ». Concrètement, HPE a installé un orchestrateur d'agents au sein d'Aruba Networking Central, « il est capable de gérer plus d'une quinzaine d'agents gérants plusieurs domaines, authentification, configuration, terminaux, ... », explique le dirigeant. Il ajoute, « c'est comme avoir un autre membre de l'équipe réseau qui est capable de fonctionner 24/24, un côté pratique pour éviter la fatigue ». Tout en reconnaissant que « si les agents IA proposent des intervenions, la décision finale revient à l'humain ». Comme pour la partie AIOps, Copilot sera le point d'entrée des administrateurs pour poser leurs questions en langage naturel. Cette capacité agentielle sera disponible au troisième trimestre 2025.

Copilot au sein de Aruba Networking Central est le point d'entrée pour mobiliser les agents IA pour la partie réseau (Crédit Photo: JC)

Côté stockage, HPE intègre nativement des serveurs MCP au sein des Alletra MP X10000. Officialisé à Barcelone en novembre dernier, le système de stockage désagrégé en mode objet adresse les besoins croissants des entreprises en matière de gestion de données non structurées pour les projets IA, l'analytique ou encore les data lakes. « L'une des tâches les plus importantes pour les entreprises clientes est de comprendre la nature des données et de les préparer, ce qu'on appelle le pipeline de données, pour entraîner ou affiner un modèle », glisse Antonio Neri. C'est un point de tension incroyable, reconnait-il. En ajoutant la couche MCP , « le stockage peut participer activement aux workflows des agents. Chaque tâche exécutée par un utilisateur via une API AWS S3, de la création de buckets au déplacement et à la lecture d'objets, peut désormais être automatisée par des agents travaillant de concert au sein même de la baie », précise Jim O'Dorisio, SVP GM chez HPE Storage.

Suivez-nous