La pression continuera de croître pour les entreprises et les opérateurs de datacenters afin d'offrir une plus grande efficacité informatique et des prévisions de disponibilité. (crédit : Sergei Starostin / Pexels)

Les équipes informatiques des datacenters doivent trouver un équilibre entre la nécessité de consommer moins d'électricité et celle d'utiliser des puces de dernière génération gourmandes en énergie. Un défi loin d'être gagné d'avance.

Les puces serveur de pointe font tourner les têtes pour leur potentiel d'amélioration des performances, mais les processeurs de dernière génération dégagent aussi plus de chaleur que les anciennes conceptions. Un casse-tête pour les opérateurs de datacenters qui auront du mal à comprendre quoi faire, d'autant que les conseils des fabricants de puces en la matière sont faméliques. Dans le même temps, le rôle que les équipements informatiques peuvent jouer dans les efforts d'efficacité énergétique va être de plus en plus scruté. Ces tendances interdépendantes font partie des principales prévisions que l'Uptime Institute fait pour les datacenters cette année. « Les opérateurs auront du mal avec les nouvelles puces pour serveur plus chaudes », a déclaré Jacqueline Davis, analyste de recherche chez Uptime, lors d'une webconférence sur les prévisions 2023 des datacenters de l'institut. Pendant ce temps, « l'accent mis sur l'efficacité énergétique va s'étendre pour inclure l'équipement informatique lui-même, ce qui, selon nous, prend du retard ».

Les datacenters en construction aujourd'hui doivent rester économiquement compétitifs et techniquement au point pendant 10 à 15 ans, mais les dernières technologies de puce amènent les opérateurs à remettre en question les directives de conception traditionnelles. « La conception du datacenter doit répondre aux exigences d'alimentation et de refroidissement des serveurs, et pendant des années, celles-ci ont été constantes. Les concepteurs pouvaient prévoir quatre à six kilowatts par rack », a déclaré Daniel Bizo, directeur de recherche chez Uptime. « Les actualisations informatiques successives n'ont pas nécessité de mises à niveau de l'infrastructure d'alimentation ou de refroidissement ». Maintenant cela change. La densité de puissance par rack et par châssis de serveur augmente. Les processeurs Xeon Scalable d'Intel de 4e génération, nommés Sapphire Rapids, ont une puissance de conception thermique (TDP) allant jusqu'à 350 watts, par exemple, et les processeurs Epyc de quatrième génération d'AMD, nommés Genoa, grimpent jusqu'à 360 watts. « Les futures feuilles de route des produits appellent des processeurs de serveur grand public avec un TDP de 500 à 600 watts seulement dans les prochaines années », a déclaré Daniel Bizo. Et donc cette tendance va bientôt commencer à déstabiliser les hypothèses de conception des installations alors que nous voyons les serveurs grand public approcher ou dépassant un kilowatt chacun. Déjà, les systèmes de calcul haute performance (HPC) spécialisés basés sur des GPU peuvent nécessiter des centaines de watts par puce à la puissance maximale. En plus d'une puissance thermique élevée, ils ont des limites de température plus basses.

Priorité à l'efficacité énergétique pour passer à l'informatique

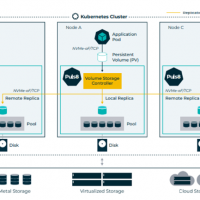

« Ils placent effectivement une double contrainte sur les systèmes de refroidissement car ils produisent plus d'énergie thermique, et beaucoup d'entre eux vont également nécessiter des températures de fonctionnement plus basses », a déclaré Daniel Bizo. Éliminer une grande quantité de chaleur pour atteindre une basse température est techniquement difficile, et cela va pousser les opérateurs à aborder le refroidissement différemment, a-t-il déclaré. Par exemple, certains opérateurs de datacenters envisageront de prendre en charge le refroidissement liquide direct. Le dilemme de conception posé par les applications HPC de niche peut être considéré comme un avertissement précoce des problèmes de consommation d'énergie et de refroidissement que les processeurs à TDP élevé apporteront au marché des serveurs d'entreprise grand public. « Cela nécessitera maintenant des spéculations », a déclaré Daniel Bizo. « Quelle sera la puissance d'un rack informatique type ? Quelle sera la puissance des racks haute densité ? Quels modes de refroidissement les centres de données devront-ils prendre en charge d'ici la fin de cette décennie ? » Une approche conservatrice pourrait être de continuer avec des conceptions de rack à faible densité, mais cela augmente le risque qu'un centre de données devienne trop limité ou même obsolète avant l'heure. Cependant, une approche de conception plus agressive qui nécessite des racks hautement densifiés augmente le risque de dépenses excessives pour des capacités et des capacités sous-utilisées, a averti Daniel Bizo. « Les opérateurs vont être confrontés à divers choix dans la gestion des technologies informatiques de nouvelle génération. Ils peuvent limiter les températures de l'air et accepter une pénalité d'efficacité. Ou, comme l'ASHRAE le recommande avec sa classe de norme thermique H1, ils peuvent créer des environnements dédiés pour ces systèmes informatiques à température limitée afin de minimiser l'impact sur l'efficacité des installations. Ou ils peuvent faciliter une conversion au refroidissement liquide direct », fait savoir Daniel Bizo. Alors que la physique des semi-conducteurs est ici le moteur physique sous-jacent, l'économie des infrastructures va façonner la façon dont cela se passera pour la conception et l'exploitation des datacenters. Et avec peu de conseils de la part des fabricants de puces, l'adaptabilité va être la clé.

La pression continuera de croître pour les entreprises et les opérateurs de datacenters pour offrir une plus grande efficacité informatique et des prévisions de disponibilité. Dans le passé, la responsabilité incombait à l'établissement. Les opérateurs de datacenters, qui ont supporté le poids des exigences de durabilité et d'efficacité, ont réalisé des gains considérables en termes d'efficacité de l'utilisation de l'énergie (PUE) au cours des 15 dernières années environ, poursuit Daniel Bizo. Pour rappel, le PUE mesure le rapport entre l'énergie utilisée par l'équipement informatique et l'énergie utilisée par l'ensemble du datacenter. Grâce à des initiatives telles que la séparation de l'air, des tolérances de température plus flexibles, un contrôle plus strict du refroidissement, des ventilateurs et de la distribution de l'alimentation, et l'utilisation de sources d'énergie renouvelables, les installations sont beaucoup plus efficaces dans leur utilisation des ressources. « Les opérateurs de datacenters ont fait beaucoup de choses en faveur de la durabilité. Dans le même temps, l'informatique, dans l'ensemble, a été absente de ces discussions », explique Daniel Bizo. « Cela devient de plus en plus intenable. Pourquoi ? Eh bien, tout simplement parce que ce qui reste en termes de gains d'efficacité se cache dans les performances énergétiques de l'informatique ».

La pression monte dans quatre domaines clé

Selon Uptime, la pression s'accroit dans 4 domaines principaux, à savoir :

1. Résistance des villes aux nouveaux grands datacenters : depuis 2019, les inquiétudes concernant la disponibilité de l'électricité et des terrains ont conduit à de plus grandes restrictions sur la construction de nouveaux datacenters, et cela devrait s'intensifier. À Francfort, en Allemagne, par exemple, les dernières constructions d'infrastructures cloud et de colocation sont limitées à des zones spécifiques en raison de l'utilisation tentaculaire des terres et des changements dans l'horizon de la ville ;

2. Disponibilité limitée de l'alimentation du réseau pour prendre en charge l'augmentation de la capacité du datacenter : Uptime a cité deux régions (Dublin en Irlande et Virginie du Nord aux US) où les réseaux électriques sont tendus et où les services publics d'électricité ont interrompu ou limité les nouvelles connexions en raison de déficits de capacité de production ou de transmission ;

3. Augmentation de la réglementation régissant la durabilité et la réduction des émissions de carbone, et exigences de déclaration plus strictes : dans l'Union européenne, les datacenters sont confrontés à de nouvelles exigences de déclaration de consommation d'énergie plus détaillées et devront, par exemple, rendre leurs mesures de performance énergétique accessibles au public. Des initiatives similaires apparaissent maintenant aux États-Unis, selon Uptime ;

4. Coûts élevés de l'énergie : les prix de l'énergie et, par conséquent, les prix de l'électricité étaient sur une trajectoire ascendante avant l'invasion de l'Ukraine par la Russie. Les prix de gros à terme de l'électricité montaient déjà en flèche sur les marchés européen et américain en 2021. La trajectoire reste celle d'une électricité plus coûteuse, et cela crée un environnement propice à la volatilité.

Faire face aux prix élevés de l'énergie, aux rapports sur le carbone et aux insuffisances de capacité du réseau a toujours été le domaine des exploitants d'installations. Mais il y a des rendements décroissants du côté des installations - des interventions plus importantes offrent de moins en moins d'avantages -, selon Uptime. En revanche, l'informatique est mûre pour améliorer les performances énergétiques des datacenters, en particulier dans le domaine du matériel serveur. Le matériel de serveur sous-utilisé et inefficace est un domaine clé dans lequel l'informatique peut améliorer les performances énergétiques. Avoir moins de serveurs avec des mesures de performances plus élevées pourrait, par exemple, générer des gains d'énergie. Le service informatique peut faire de meilleurs choix de configuration matérielle et utiliser la consolidation dynamique de la charge de travail, note Daniel Bizo. Les fonctions de gestion de l'alimentation, telles que les états d'économie d'énergie et les fonctions de limitation de l'alimentation, pourraient également offrir des gains d'efficacité énergétique importants. La nécessité de mieux concevoir l'infrastructure IT pour proposer une meilleure efficacité énergétique ne fera qu'augmenter. Chaque watt économisé par l'informatique réduit les pressions ailleurs, et les exigences de reporting révéleront bientôt le potentiel d'une plus grande efficacité énergétique cachée dans l'infrastructure informatique, affirme Uptime. « Les équipes d'infrastructure et d'exploitation informatiques devront, assez prochainement, démontrer qu'elles font tout ce qu'elles peuvent pour améliorer l'utilisation typique de l'infrastructure de serveur », avance Daniel Bizo.

Des coûts en géopolitique, cloud et datacenters à évaluer

Pour récapituler, deux des prédictions d'Uptime pour 2023 verront l'informatique accorder plus d'attention au matériel de serveur : les demandes de puissance augmentent à mesure que des processeurs de serveur plus puissants arrivent sur le marché ; et les attentes en matière d'efficacité énergétique touchent désormais les équipes informatiques, et pas seulement les équipes des installations.

Pour compléter les cinq prévisions d'Uptime concernant les datacenters pour 2023, on retiendra que la géopolitique continuera d'aggraver les inquiétudes concernant la chaîne d'approvisionnement : Uptime cite à ce sujet les tensions politiques entre l'alliance occidentale dirigée par les États-Unis, la Chine et la Russie qui augmentent le risque de perturbations de la chaîne d'approvisionnement. Les chaînes d'approvisionnement en semi-conducteurs et les systèmes de câbles sous-marins sont particulièrement vulnérables à d'éventuelles confrontations économiques et militaires, prédit la société. Les migrations vers le cloud feront par ailleurs l'objet d'un examen plus approfondi : dans une période de tension économique et d'incertitude, le coût de la migration et la menace d'une montée en flèche des coûts du cloud ralentiront ou dissuaderont certaines migrations critiques, selon les prévisions de disponibilité. Les coûts des datacenters sont appelés à augmenter : les coûts des installations informatiques et de ces infrastructures ont connu une tendance à la baisse ces dernières années. Cette tendance est maintenant terminée et les prix devraient augmenter, prédit Uptime. Les problèmes de chaîne d'approvisionnement, les prix de l'énergie plus élevés et la main-d'oeuvre plus chère ont tous contribué à la hausse des coûts. Cela ne signifie pas que des prix plus élevés vont freiner la demande de datacenters, mais ils sont susceptibles de stimuler de nouveaux efforts pour améliorer l'efficacité.

Suivez-nous